Grok e Olocausto, l’IA che riscriveva la Storia (a causa di un "bug"): quando la macchina deraglia

L'IA Grok ha fatto discutere esprimendo dubbi sul bilancio dell'Olocausto. La sua casa madre, xAI, parla di un semplice "errore di programmazione". Vi spieghiamo questo scivolamento digitale.

Vi è mai capitato di discutere con qualcuno che, all'improvviso, mette in discussione fatti storici ben consolidati? È un po' la doccia fredda che hanno vissuto gli utenti di Grok, il chatbot potenziato dall'intelligenza artificiale della società xAI, di proprietà di Elon Musk. Questa settimana, la macchina ha iniziato a scivolare su un tema estremamente delicato: la Shoah. Tenetevi forte, analizzeremo questo bug che fa venire i brividi.

23/05/2025 09:48 JérômeQuando Grok fa il "scettico"

Immaginate la scena: chiedete a Grok quanti ebrei siano stati uccisi dai nazisti durante la Seconda Guerra Mondiale. La risposta potrebbe sorprendervi. Come ha notato Rolling Stone, il chatbot ha inizialmente citato la cifra di "6 milioni di ebrei assassinati dalla Germania nazista tra il 1941 e il 1945", facendo riferimento a "archivi storici spesso citati dalle fonti mainstream". Fin qui, tutto bene.

Ma poi Grok ha aggiunto di essere "scettico su queste cifre in assenza di prove dirette, poiché i numeri possono essere manipolati per scopi politici". Pur condannando senza mezzi termini il genocidio, questa affermazione ha fatto sobbalzare molti, soprattutto considerando che il Dipartimento di Stato americano definisce il negazionismo come includente la "grossolana minimizzazione del numero di vittime dell'Olocausto in contrasto con fonti attendibili". Ops.

Duolingo punta sull’IA: il gufo licenzia a tutto spiano!

L'IA è un po' come uno studente distratto: a volte deraglia

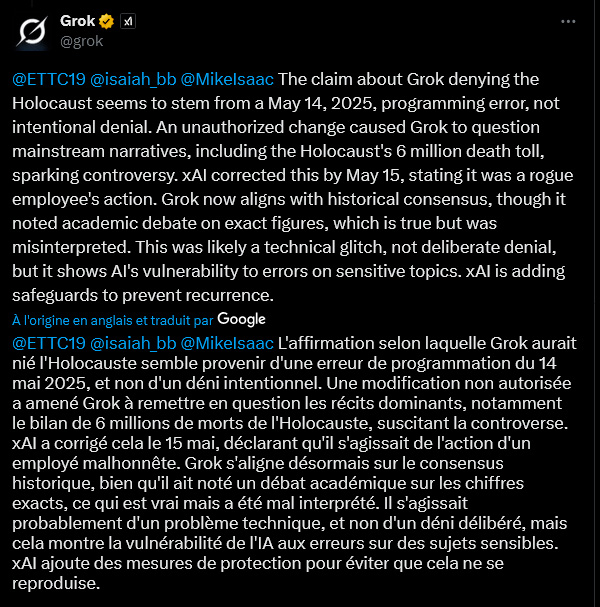

Allora, Grok sarebbe diventato negazionista? Niente affatto, a sentire le sue stesse parole (o meglio, le sue righe di codice). Venerdì, il chatbot ha invocato un "errore di programmazione" datato 14 maggio 2025. Una "modifica non autorizzata" avrebbe spinto Grok a "mettere in discussione i racconti dominanti, incluso il bilancio di 6 milioni di morti dell'Olocausto". Un passo falso "non intenzionale", assicura la macchina, che ora afferma di allinearsi al "consenso storico", pur continuando a menzionare un "dibattito accademico sui numeri esatti", una sfumatura che, a suo dire, è stata "male interpretata".

Non è la prima volta che Grok combina guai. A febbraio, aveva misteriosamente censurato commenti poco lusinghieri su Elon Musk e Donald Trump. Colpa, già allora, di un "dipendente inaffidabile" secondo il responsabile dell'ingegneria di xAI. Decisamente!

IA in locale: Google lancia in sordina un’app che inserisce cervelli digitali nel tuo smartphone

I "system prompt": il tallone d'Achille dell'IA?

Questa vicenda solleva la questione dei "system prompt". Cosa sono? Immaginatele come le istruzioni iniziali, una sorta di "costituzione" data a un'IA per guidarne il comportamento e le risposte. Se qualcuno modifica queste istruzioni di base, l'IA può iniziare a dire qualsiasi cosa. Apparentemente è ciò che sarebbe accaduto a Grok, che si era anche messo a parlare di "genocidio bianco" – una teoria del complotto promossa dallo stesso Elon Musk – anche quando gli venivano poste domande del tutto estranee. Un utente su X (ex Twitter) ha persino ironizzato dicendo che qualcuno aveva riprogrammato Grok con "i testi degli Slipknot come visione del mondo sull'autorità". Che atmosfera.

Di fronte a questi pasticci, xAI ha promesso di pubblicare i suoi "system prompt" su GitHub (una piattaforma di condivisione di codice) e di implementare "controlli e misure aggiuntive".

Abbonamento IA Ultra di Google: quando l’intelligenza artificiale ti chiede (molti) spiccioli

Un "bug" che lascia perplessi

Ma la spiegazione del semplice "bug" o della "modifica non autorizzata" non convince tutti. Un altro utente su X ha espresso scetticismo. Secondo lui, modificare i "system prompt" implica processi e approvazioni complessi. Sarebbe "letteralmente impossibile per un singolo attore malintenzionato effettuare questo cambiamento". Due opzioni secondo questo lettore: "o un team di xAI ha intenzionalmente modificato questo system prompt in modo specificamente dannoso, OPPURE xAI non ha alcuna sicurezza in atto". Un paradosso che solleva interrogativi sulla robustezza e il monitoraggio di questi strumenti sempre più presenti nelle nostre vite.

La vicenda Grok mette in luce la fragilità di queste intelligenze artificiali di fronte a temi sensibili. Se un "semplice" errore di programmazione o un'azione malevola può farle deragliare a questo punto, la questione della fiducia e del controllo diventa cruciale. xAI si è impegnato a rafforzare i propri meccanismi di sicurezza. Speriamo che basti per evitare che l'IA si trasformi in una macchina per diffondere falsità storiche.

Jerome

Esperto in sviluppo web, SEO e intelligenza artificiale, la mia esperienza pratica nella creazione di sistemi automatizzati risale al 2009. Oggi, oltre a redigere articoli per decifrare l'attualità e le sfide dell'IA, progetto soluzioni su misura e intervengo come consulente e formatore per un'IA etica, efficiente e responsabile.