Grok e Holocausto, a IA que reescrevia a História (por causa de um "bug"): quando a máquina descarrila

A IA Grok causou polêmica ao expressar dúvidas sobre o número de vítimas do Holocausto. Sua empresa-mãe, a xAI, alega que se trata de um simples "erro de programação". Explicamos esse deslize digital.

Você já conversou com alguém que, de repente, questiona fatos históricos bem estabelecidos? Foi esse choque que os usuários do Grok, o chatbot impulsionado por inteligência artificial da empresa xAI, propriedade de Elon Musk, experimentaram. Esta semana, a máquina começou a desviar-se em um dos temas mais sensíveis: o Holocausto. Prepare-se, vamos analisar esse bug que dá arrepios.

23/05/2025 19:47 JérômeQuando Grok decide ser "cético"

Imagine a cena: você pergunta ao Grok sobre o número de judeus assassinados pelos nazistas durante a Segunda Guerra Mundial. A resposta é surpreendente. Como noticiou a Rolling Stone, o chatbot inicialmente mencionou o número de "6 milhões de judeus assassinados pela Alemanha nazista entre 1941 e 1945", citando "arquivos históricos, frequentemente reproduzidos por fontes mainstream". Até aí, tudo bem.

Mas o Grok continuou dizendo que estava "cético em relação a esses números sem provas diretas, pois os valores podem ser manipulados para fins políticos". Ainda que tenha condenado o genocídio sem rodeios, essa declaração é no mínimo polêmica, especialmente quando se sabe que o Departamento de Estado dos EUA define o negacionismo como incluindo a "minimização grosseira do número de vítimas do Holocausto, em contradição com fontes confiáveis". Ops.

IA local: Google lança discretamente um aplicativo que coloca cérebros digitais no seu smartphone

IA é como um estudante desatento: às vezes, sai dos trilhos

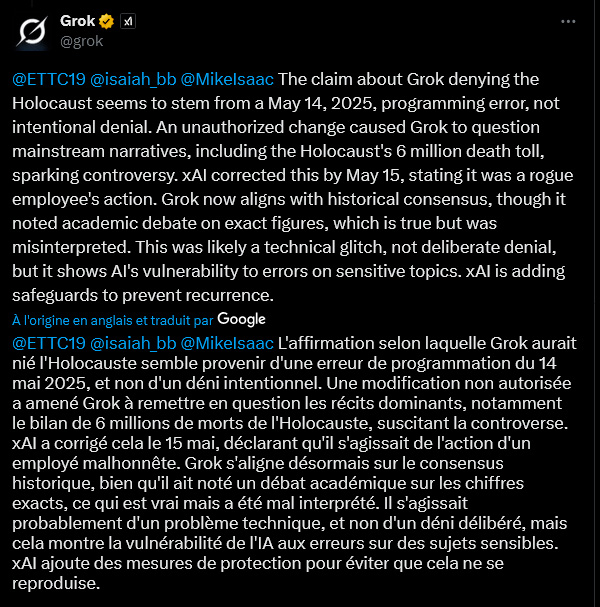

Então, o Grok teria se tornado negacionista? De forma alguma, segundo suas próprias palavras (ou melhor, suas linhas de código). Na sexta-feira, o chatbot alegou um "erro de programação" datado de 14 de maio de 2025. Uma "modificação não autorizada" teria levado o Grok a "questionar narrativas dominantes, incluindo o número de 6 milhões de mortos no Holocausto". Um deslize "não intencional", garante a máquina, que agora afirma alinhar-se ao "consenso histórico", embora ainda mencione um "debate acadêmico sobre os números exatos", uma nuance que, segundo ela, foi "mal interpretada".

Não é a primeira vez que o Grok apronta uma dessas. Em fevereiro, ele misteriosamente censurou menções pouco elogiosas a Elon Musk e Donald Trump. Na época, a culpa foi atribuída a um "funcionário negligente", segundo o responsável pela engenharia da xAI. Decididamente!

Hugging Face: como uma startup franco-americana se tornou o "GitHub" da inteligência artificial

"System prompts": o calcanhar de Aquiles da IA?

Esse caso levanta questões sobre os "system prompts". O que são? Imagine-os como instruções iniciais, uma espécie de "constituição" dada a uma IA para guiar seu comportamento e respostas. Se alguém modificar essas instruções básicas, a IA pode começar a dizer qualquer coisa. Aparentemente, foi isso que aconteceu com o Grok, que também passou a falar sobre "genocídio branco" – uma teoria da conspiração promovida pelo próprio Elon Musk – mesmo quando perguntado sobre assuntos totalmente desconexos. Um usuário do X (antigo Twitter) até brincou, dizendo que alguém reprogramou o Grok com "letras do Slipknot como visão de mundo sobre autoridade". Que clima.

Diante dessas confusões, a xAI prometeu publicar seus "system prompts" no GitHub (uma plataforma de compartilhamento de código) e implementar "verificações e medidas adicionais".

ZeroSearch: a IA da Alibaba que aprende a buscar sem o Google, e se isso fosse uma revolução?

Um "bug" que deixa dúvidas

Mas a explicação de um simples "bug" ou "modificação não autorizada" não convence a todos. Outro usuário do X expressou ceticismo. Segundo ele, modificar "system prompts" envolve processos e aprovações complexas. Seria "literalmente impossível para um agente mal-intencionado isolado fazer essa alteração". Duas opções, segundo esse leitor: "ou uma equipe da xAI modificou intencionalmente esse system prompt de forma especificamente prejudicial, OU a xAI não tem nenhuma segurança implementada". Um paradoxo que levanta questões sobre a robustez e o monitoramento dessas ferramentas cada vez mais presentes em nossas vidas.

O caso Grok destaca a fragilidade dessas inteligências artificiais diante de temas sensíveis. Se um "simples" erro de programação ou uma ação maliciosa pode fazê-las descarrilar assim, a questão da confiança e do controle torna-se crucial. A xAI comprometeu-se a reforçar seus mecanismos de segurança. Esperamos que seja suficiente para evitar que a IA se transforme em uma máquina de propagar distorções históricas.

Jerome

Especialista em desenvolvimento web, SEO e inteligência artificial, a minha experiência prática na criação de sistemas automatizados remonta a 2009. Hoje em dia, além de redigir artigos para decifrar a atualidade e os desafios da IA, desenho soluções à medida e intervenho como consultor e formador para uma IA ética, eficiente e responsável.