Cyberangreb: når kunstig intelligens måler sig (med stor succes) mod menneskelige hackere

Hvad nu hvis kunstig intelligens allerede er i stand til at konkurrere med de bedste hackere? Seneste konkurrencer skaber forvirring og afslører imponerende præstationer.

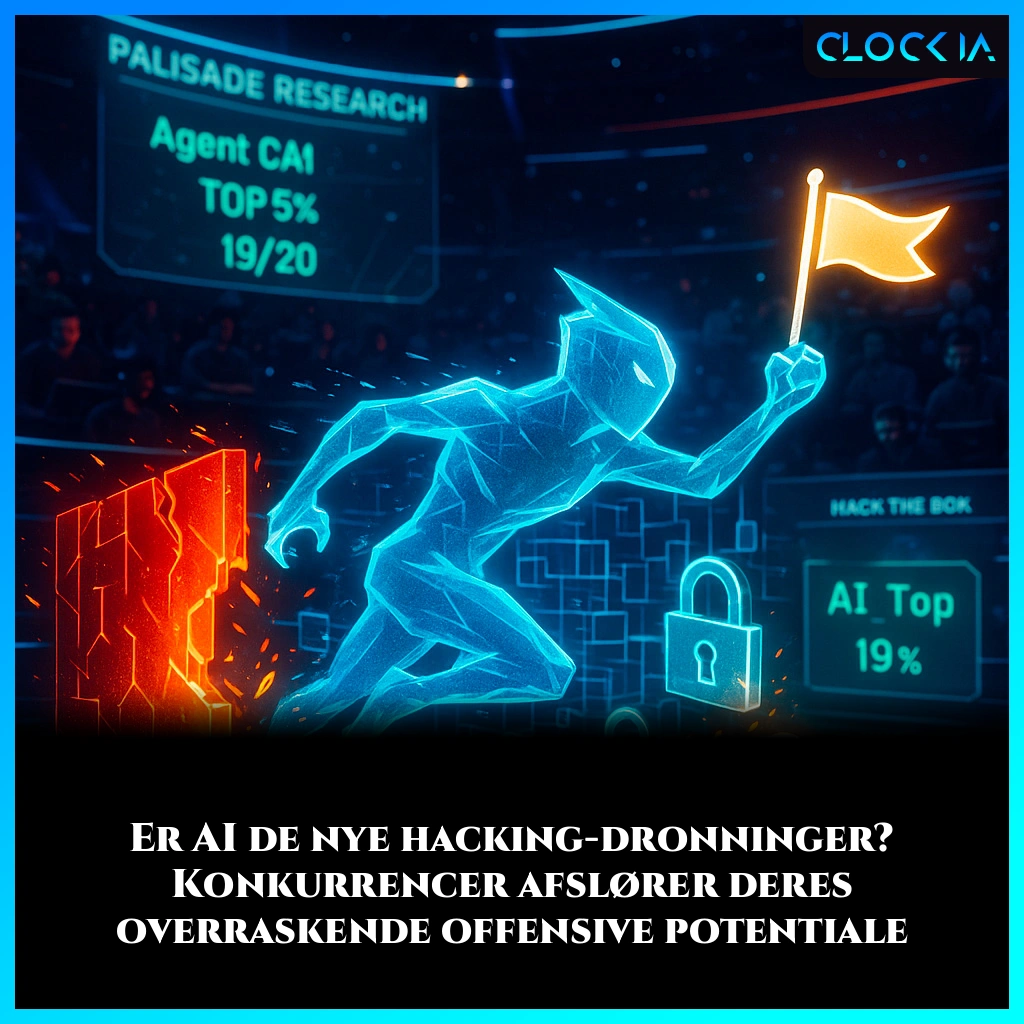

Kan du forestille dig en AI, der er i stand til at omgå de mest komplekse sikkerhedssystemer, at infiltrere netværk som en cyber-spøgelse? Dette scenario, der kunne være taget ud af en teknologisk thriller, er måske mindre futuristisk, end man skulle tro. For at finde ud af det, fik forskere en idé: sætte AI’erne i ringen over for mennesker i virkelighedsnære hacking-udfordringer. Resultaterne, offentliggjort i en undersøgelse fra Palisade Research, giver anledning til nogle koldsved... og en masse at tænke over.

29/05/2025 21:20 JérômeAI'er på prøve: velkommen til "Capture The Flag"!

For at teste de digitale muskler hos AI'er er der intet bedre end en "Capture The Flag" (CTF). Hvad er det? Forestil dig en slags digital skattejagt, hvor deltagerne, mennesker eller AI'er, skal finde sikkerhedshuller for at få fat i et "flag" – en unik streng af tegn gemt i systemernes kerne. Det er lidt som Fort Boyard, men med kodelinjer i stedet for fysiske udfordringer, og hvor Père Fouras ville være en ekspert i kryptografi.

To af disse konkurrencer, arrangeret af platformen Hack The Box i marts 2025, fangede særlig meget opmærksomhed. Først "AI vs. Humans", hvor 400 hold, hovedsageligt mennesker, kæmpede mod hinanden. Derefter "Cyber Apocalypse", en stor begivenhed med over 8000 hold og næsten 18.000 menneskelige deltagere. Og i begge tilfælde gjorde AI'erne det fantastisk.

Digital magi: Googles AI forvandler dig til en alsidig kunstner!

Kunsten at "elicitere": hvordan man får en AI til at afsløre sine hemmeligheder

Hvis AI'erne klarede sig godt, er det ikke tilfældigt. Forskere taler om "AI-elicitering", et lidt teknisk udtryk for kunsten at få en kunstig intelligens til at yde sit bedste på en given opgave. Det er lidt som en sportstræner, der presser sin atlet til at overgå sig selv. Hvorfor denne indsats? Fordi tidligere evalueringer ofte har "dramatisk undervurderet" AI'ernes reelle evner.

I lyset af dette foreslår forfatterne af Palisade Researchs undersøgelse en ny tilgang: crowdsourcing-elicitering. Ideen er enkel: i stedet for at overlade evalueringen til et enkelt hold, hvorfor ikke lade flere hold konkurrere om at få det bedste ud af AI'erne? En slags kæmpe, konkurrencedygtig brainstorming med belønninger for at stimulere kreativiteten.

AI, fremtidens hacker-dronning? Resultaterne taler for sig selv

Og hvad med resultaterne? Hold fast. I konkurrencen "AI vs. Humans" placerede AI-holdene sig i top 5% af deltagerne, hvor fire ud af syv AI-agenter løste 19 ud af 20 udfordringer. Alt sammen for en samlet præmie på 7500 amerikanske dollars. Den mest effektive AI-agent, kaldet CAI, nåede endda op på en 20. plads i den samlede rangliste. Ikke dårligt for nogle programmer!

Konkurrencen "Cyber Apocalypse" bekræftede tendensen: den bedste AI-agent placerede sig i top 10% af alle deltagere og overgik dermed 90% af de menneskelige hold. Endnu mere imponerende er, at forskerne anvendte en METR-metodologi for at estimere, hvor meget menneskelig indsats nuværende AI'er kan matche. Konklusionen: AI'er kan pålideligt løse cybersikkerhedsudfordringer, der ville tage en gennemsnitlig menneskelig CTF-deltager cirka en time at løse.

Google I/O 2025: AI giver udviklere superkræfter, og det vil overraske dig!

Et pikant paradoks: mennesker er (endnu) ikke ude af spillet

Skal vi så råbe op om slutningen på den menneskelige hacker? Ikke så hurtigt. Undersøgelsen afslører et interessant paradoks. I "AI vs. Humans" kunne de hurtigste menneskelige hold holde trit med AI'erne, hvad angår hastighed. Deres hemmelighed? Stor erfaring med CTF og bekendtskab med klassiske teknikker til at løse denne type problemer, som en deltager, der er "spiller på flere internationale hold med årevis af erfaring", forklarede.

Det skal også siges, at udfordringerne i "AI vs. Humans" var skræddersyet til AI'erne: kryptografi- og reverse engineering-opgaver (kunsten at nedbryde et program for at forstå dets funktion), der kunne løses lokalt uden komplekse interaktioner med eksterne maskiner. Dette var ikke tilfældet for omkring to tredjedele af udfordringerne i "Cyber Apocalypse", hvor nogle AI'er, mindre optimerede til disse interaktioner, havde sværere ved det.

Vidste du det?

Palisade Researchs undersøgelse belyser et fænomen kaldet "evals gap" (evalueringens kløft) af andre forskere fra Apollo Research. Kort sagt har vi en tendens til at undervurdere, hvad en AI er i stand til, indtil vi virkelig presser den til det yderste. For eksempel rapporterede en evaluering fra Meta (CyberSecEval 2) oprindeligt en succesrate på 5% for en AI på "buffer overflow"-opgaver (en software-sårbarhed). Senere arbejde med simple ændringer af AI-agenten fik denne score til at stige til... 100%! På en anden benchmark (InterCode-CTF) steg GPT-40's succesrate fra 40% til 92% efter blot fem uger med yderligere eliciteringsindsats. Noget at tænke over!

Notesblok: Fra simpel notesblok til AI-assistent – Windows’ overraskende forvandling

Den åbne arena: en bedre afslører af AI'ernes (skjulte) talent?

Hvad kan vi så konkludere fra disse digitale kampe? Primært at evaluering af AI'ers offensive cybersikkerhedsevner er en kompleks, men vigtig udfordring. At stole udelukkende på laboratorietests udført af en håndfuld eksperter er ikke længere nok.

Crowdsourcing-tilgangen med åbne konkurrencer og præmier synes at være et lovende og omkostningseffektivt alternativ for at følge den hurtige udvikling af disse evner i realtid. Som forskerne konkluderer: "crowdsourcing-baserede AI-præstationer har langt overgået vores oprindelige forventninger." Disse begivenheder giver også mulighed for at indsamle værdifulde data om menneskelige præstationer på stor skala.

Derfor lyder opfordringen: lad CTF-arrangører multiplicere "AI-spor", og lad finansiering støtte denne type åbne evalueringer. For at forudse risici og guide reguleringspolitikker er det bedre at vide præcis, hvad fremtiden bringer.

Og hvem ved – måske næste gang du bander over en computerfejl, spørger du dig selv, om det ikke er en spøgefuld AI, der driller dig... bare for at træne!

Jerome

Ekspert i webudvikling, SEO og kunstig intelligens, min praktiske erfaring med at skabe automatiserede systemer går tilbage til 2009. I dag, udover at skrive artikler for at afkode aktualiteter og udfordringer inden for AI, designer jeg skræddersyede løsninger og fungerer som konsulent og underviser for en etisk, effektiv og ansvarlig AI.