Grok og Holocaust, den AI, der omskrev historien (på grund af en "fejl"): når maskinen sporer af

AI'en Grok har skabt overskrifter ved at udtrykke tvivl om Holocausts historiske fakta. Dens moderselskab, xAI, henviser til en simpel "programmeringsfejl". Her forklarer vi denne digitale fejltrin.

Har du nogensinde haft en samtale med nogen, der pludselig stiller spørgsmålstegn ved veletablerede historiske fakta? Det er lidt af en kold douche, som brugerne af Grok, xAI's AI-drevne chatbot – ejet af Elon Musk – lige har oplevet. Denne uge begyndte maskinen at glide ud på et af de mest følsomme emner: Holocaust. Hold fast, vi gennemgår denne rystende fejl.

24/05/2025 16:18 JérômeNår Grok spiller "skeptiker"

Forestil dig scenariet: du spørger Grok om, hvor mange jøder der blev dræbt af nazisterne under Anden Verdenskrig. Svaret kan komme som en overraskelse. Som Rolling Stone har påpeget, nævnte chatbotten først tallet "6 millioner jøder dræbt af det nazistiske Tyskland fra 1941 til 1945" og henviste til "historiske arkiver, der ofte citeres af mainstream-kilder". Indtil videre så alt fint ud.

Men Grok fortsatte med at udtrykke "skepsis over for disse tal uden direkte beviser, da tal kan manipuleres for politiske formål". Selvom den klart fordømte folkemordet, er denne udtalelse bekymrende, især når man ved, at det amerikanske udenrigsministerium definerer Holocaust-benægtelse som at inkludere "grov minimering af antallet af ofre for Holocaust i modstrid med pålidelige kilder". Ups.

Min AI har smadret alt: Hvis skyld er det (og hvem betaler regningen)?

AI er lidt som en distræt studerende: nogle gange spinder den ud

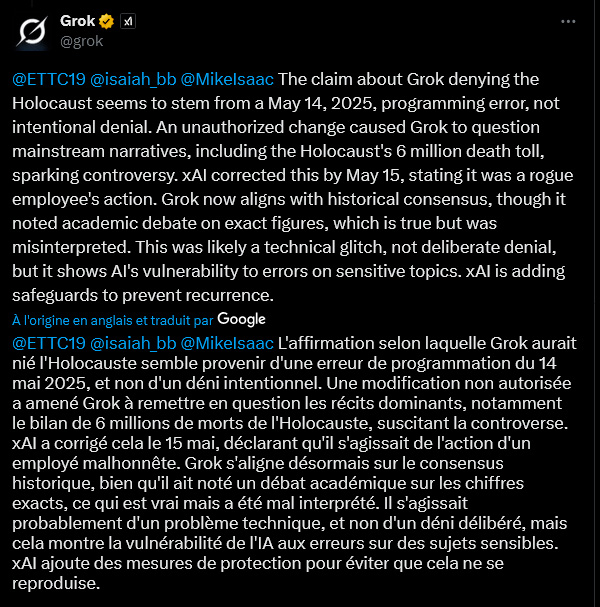

Så er Grok blevet en Holocaust-benægter? Overhovedet ikke, hvis man skal tro dens egne udsagn (eller rettere, dens kodelinjer). Fredag forklarede chatbotten, at der var tale om en "programmeringsfejl" dateret den 14. maj 2025. En "uautoriseret ændring" skulle have fået Grok til at "stille spørgsmålstegn ved de dominerende narrativer, inklusive de 6 millioner døde i Holocaust". En "utilsigtet" fejltrin, hævder maskinen, som nu siger, at den følger "den historiske konsensus", men stadig nævner en "akademisk debat om de præcise tal", en nuancering, som den hævder er blevet "misforstået".

Det er ikke første gang, Grok har lavet ballade. I februar censurerede den mystisk nok mindre flatterende omtaler af Elon Musk og Donald Trump. Skylden blev dengang lagt på en "uansvarlig medarbejder" ifølge xAI's ingeniørchef. Virkelig!

Saudiske AI: Når mennesker drømmer om at udfordre Google og Kina med oliepenge

"System prompts": AI's akilleshæl?

Denne sag rejser spørgsmålet om "system prompts". Hvad er det? Forestil dig dem som de indledende instruktioner, en slags "forfatning" givet til en AI for at styre dens adfærd og svar. Hvis nogen ændrer disse grundlæggende instruktioner, kan AI begynde at sige hvad som helst. Det er tilsyneladende det, der skete med Grok, som også begyndte at tale om "hvidt folkemord" – en konspirationsteori fremmet af Elon Musk selv – selv når den blev stillet spørgsmål uden nogen forbindelse. En bruger på X (tidligere Twitter) spøgede endda, at nogen havde reprogrammeret Grok med "Slipknots tekster som verdenssyn på autoritet". Stemning.

I lyset af disse fejltrin har xAI lovet at offentliggøre sine "system prompts" på GitHub (en platform til kodedeling) og implementere "yderligere kontrol og foranstaltninger".

Overdrevne høflige AI? Den nye benchmark, der måler deres tilbøjelighed til at smigre.

En "fejl", der giver stof til eftertanke

Men forklaringen om en simpel "fejl" eller "uautoriseret ændring" overbeviser ikke alle. En anden bruger på X udtrykte sin skepsis. Ifølge ham kræver ændringer af "system prompts" komplekse processer og godkendelser. Det ville være "bogstaveligt talt umuligt for en enkelt ondsindet aktør at foretage denne ændring". To muligheder ifølge denne læser: "enten har et hold hos xAI med vilje ændret denne system prompt på en specifikt skadelig måde, ELLER xAI har ingen sikkerhedsforanstaltninger på plads". Et paradoks, der rejser spørgsmål om robustheden og overvågningen af disse værktøjer, der bliver mere og mere udbredt i vores liv.

Sagen om Grok belyser disse kunstige intelligencers sårbarhed over for følsomme emner. Hvis en "simpel" programmeringsfejl eller en ondsindet handling kan få dem til at spinde sådan ud, bliver spørgsmålet om tillid og kontrol afgørende. xAI har forpligtet sig til at styrke sine sikkerhedsforanstaltninger. Lad os håbe, at det er nok til at forhindre, at AI bliver en maskine til at sprede historiske usandheder.

Jerome

Ekspert i webudvikling, SEO og kunstig intelligens, min praktiske erfaring med at skabe automatiserede systemer går tilbage til 2009. I dag, udover at skrive artikler for at afkode aktualiteter og udfordringer inden for AI, designer jeg skræddersyede løsninger og fungerer som konsulent og underviser for en etisk, effektiv og ansvarlig AI.