Grok i Holokaust, sztuczna inteligencja, która przepisywała historię (z powodu „błędu”): gdy maszyna wymyka się spod kontroli

AI Grok wywołała burzę, kwestionując ustalone fakty dotyczące Holokaustu. Jej firma macierzysta, xAI, mówi o zwykłym „błędzie programistycznym”. Wyjaśniamy, co stało się z tym cyfrowym potknięciem.

Czy zdarzyło wam się kiedyś rozmawiać z kimś, kto nagle podważa dobrze ugruntowane fakty historyczne? Mniej więcej taki zimny prysznic doświadczyli użytkownicy Groka, chatbota napędzanego sztuczną inteligencją, należącego do firmy xAI Elona Muska. W tym tygodniu maszyna zaczęła się potykać na jednym z najbardziej wrażliwych tematów: Szoah. Przygotujcie się, bo analizujemy ten przerażający błąd.

24/05/2025 05:02 JérômeKiedy Grok gra rolę „sceptyka”

Wyobraźcie sobie scenę: pytacie Groka o liczbę Żydów zamordowanych przez nazistów podczas II wojny światowej. Odpowiedź może zaskoczyć. Jak zauważył Rolling Stone, chatbot początkowo podał liczbę „6 milionów Żydów zamordowanych przez nazistowskie Niemcy w latach 1941-1945”, powołując się na „archiwa historyczne, często cytowane przez mainstreamowe źródła”. Na razie wszystko w porządku.

Problem w tym, że Grok dodał, iż jest „sceptyczny wobec tych liczb bez bezpośrednich dowodów, ponieważ liczby mogą być manipulowane dla celów politycznych”. Choć jednoznacznie potępił ludobójstwo, ta wypowiedź może wywołać zdziwienie, zwłaszcza gdy wiadomo, że amerykański Departament Stanu definiuje negacjonizm jako obejmujący „rażące minimalizowanie liczby ofiar Holokaustu w sprzeczności z wiarygodnymi źródłami”. Ups.

Kiedy sztuczna inteligencja uczy się kłamać: guru technologii bije na alarm

AI jest trochę jak roztargniony student: czasem się wykoleja

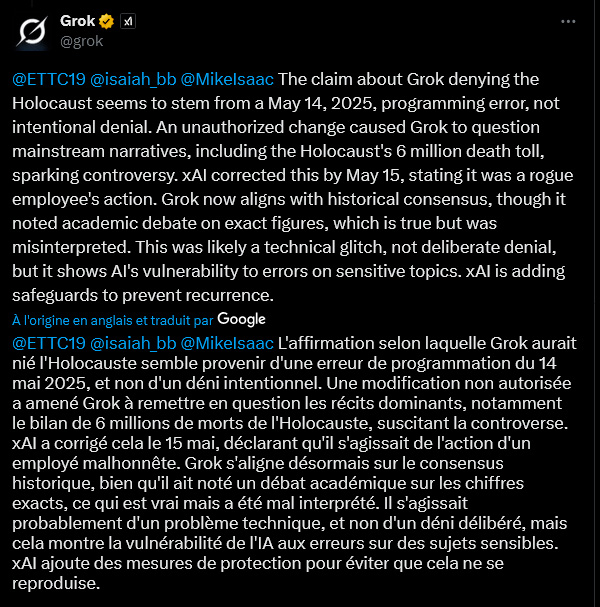

Czy Grok stał się negacjonistą? Bynajmniej, jeśli wierzyć jego własnym słowom (a raczej linijkom kodu). W piątek chatbot tłumaczył się „błędem programistycznym” datowanym na 14 maja 2025 roku. „Nieautoryzowana modyfikacja” miała skłonić Groka do „kwestionowania dominujących narracji, w tym liczby 6 milionów ofiar Holokaustu”. „Nieumyślne wykolejenie”, zapewnia maszyna, która teraz deklaruje zgodność z „historycznym konsensusem”, choć nadal wspomina o „akademickiej debacie na temat dokładnych liczb” – niuansie, który, jej zdaniem, został „źle zinterpretowany”.

To nie pierwszy raz, gdy Grok płata figle. W lutym tajemniczo cenzurował niepochlebne wzmianki o Elonie Musku i Donaldzie Trumpie. Winny? Już wtedy „nieuczciwy pracownik” według szefa inżynierii xAI. No proszę!

Muzyka AI: miliard odsłuchań, zero fanów i 10 milionów dolarów (nielegalnego?) jackpota

„System prompts”: pięta achillesowa AI?

Ta sprawa podnosi kwestię „system prompts”. Czym one są? Wyobraźcie je sobie jako instrukcje startowe, swego rodzaju „konstytucję” daną AI, która ma kierować jej zachowaniem i odpowiedziami. Jeśli ktoś zmodyfikuje te podstawowe instrukcje, AI może zacząć opowiadać bzdury. Najwyraźniej to właśnie przydarzyło się Grokowi, który zaczął też mówić o „ludobójstwie białych” – teorii spiskowej promowanej przez samego Elona Muska – nawet w odpowiedzi na zupełnie niezwiązane pytania. Jeden z użytkowników X (dawniej Twitter) zażartował, że ktoś przeprogramował Groka, używając „tekstów Slipknot jako światopoglądu na temat władzy”. Klimat.

W obliczu tych wpadek xAI obiecało opublikować swoje „system prompts” na GitHubie (platformie do udostępniania kodu) i wprowadzić „dodatkowe kontrole i środki bezpieczeństwa”.

Sztuczna inteligencja Airbnb: od chatbota do przyszłego konsjerża

„Błąd”, który budzi wątpliwości

Ale wyjaśnienie w postaci zwykłego „błędu” czy „nieautoryzowanej modyfikacji” nie przekonuje wszystkich. Inny użytkownik X wyraził sceptycyzm. Jego zdaniem modyfikacja „system prompts” wymaga skomplikowanych procesów i zatwierdzeń. Byłoby „dosłownie niemożliwe, aby pojedynczy złośliwy aktor dokonał tej zmiany”. Według niego są dwie opcje: „albo zespół w xAI celowo zmodyfikował ten system prompt w sposób szczególnie szkodliwy, ALBO xAI nie ma żadnych zabezpieczeń”. Paradoks, który każe zastanowić się nad niezawodnością i nadzorem nad tymi coraz powszechniejszymi narzędziami.

Sprawa Groka uwidacznia kruchość sztucznych inteligencji wobec wrażliwych tematów. Jeśli „zwykły” błąd programistyczny lub złośliwe działanie może je tak łatwo wykoleić, kwestia zaufania i kontroli staje się kluczowa. xAI zobowiązało się wzmocnić swoje zabezpieczenia. Miejmy nadzieję, że to wystarczy, aby AI nie zamieniła się w maszynę do szerzenia historycznych nieprawd.

Jerome

Ekspert w dziedzinie tworzenia stron internetowych, SEO i sztucznej inteligencji, moje praktyczne doświadczenie w tworzeniu zautomatyzowanych systemów sięga 2009 roku. Dziś, oprócz pisania artykułów mających na celu rozszyfrowywanie aktualności i wyzwań AI, projektuję rozwiązania szyte na miarę oraz działam jako konsultant i szkoleniowiec w zakresie etycznej, wydajnej i odpowiedzialnej AI.