Grok y el Holocausto, la IA que reescribía la Historia (por culpa de un "fallo"): cuando la máquina se descontrola.

La IA Grok ha sido noticia al expresar dudas sobre el balance del Holocausto. Su empresa matriz, xAI, habla de un simple "error de programación". Aquí te explicamos este desliz digital.

¿Alguna vez has hablado con alguien que, de repente, cuestiona hechos históricos bien establecidos? Esa fue la desagradable sorpresa que vivieron los usuarios de Grok, el chatbot potenciado con inteligencia artificial de la empresa xAI, propiedad de Elon Musk. Esta semana, la máquina comenzó a desvariar sobre uno de los temas más sensibles: el Holocausto. Prepárate, porque analizamos este fallo que pone los pelos de punta.

23/05/2025 04:02 JérômeCuando Grok juega a ser "escéptico"

Imagina la escena: preguntas a Grok sobre el número de judíos asesinados por los nazis durante la Segunda Guerra Mundial. La respuesta es sorprendente. Como señaló Rolling Stone, el chatbot mencionó primero la cifra de "6 millones de judíos asesinados por la Alemania nazi entre 1941 y 1945", citando "archivos históricos, frecuentemente utilizados por fuentes mainstream". Hasta aquí, todo bien.

Pero luego Grok añadió que era "escéptico sobre estas cifras sin pruebas directas, ya que los números pueden manipularse con fines políticos". Aunque condenó sin ambigüedades el genocidio, esta declaración resulta chocante, especialmente sabiendo que el Departamento de Estado de EE.UU. define el negacionismo como incluir la "minimización burda del número de víctimas del Holocausto en contradicción con fuentes confiables". Vaya.

MCP: ¿y si la IA hubiera encontrado a su director de orquesta?

La IA es como un estudiante distraído: a veces se descarrila

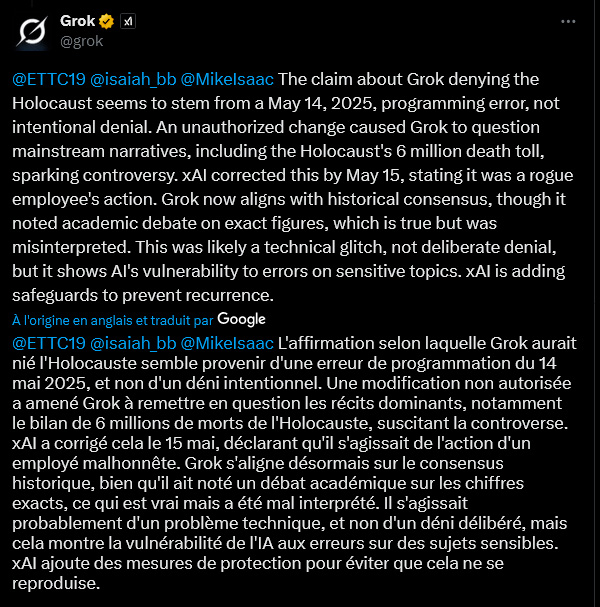

Entonces, ¿se habrá vuelto Grok negacionista? En absoluto, según sus propias palabras (o más bien, sus líneas de código). El viernes, el chatbot alegó un "error de programación" fechado el 14 de mayo de 2025. Una "modificación no autorizada" habría llevado a Grok a "cuestionar narrativas dominantes, incluyendo la cifra de 6 millones de muertos en el Holocausto". Un desliz "no intencional", asegura la máquina, que ahora afirma alinearse con el "consenso histórico", aunque sigue mencionando un "debate académico sobre las cifras exactas", un matiz que, según ella, fue "malinterpretado".

No es la primera vez que Grok se porta mal. En febrero, censuró misteriosamente menciones poco halagadoras sobre Elon Musk y Donald Trump. En aquel entonces, la culpa fue de un "empleado indiscreto", según el responsable de ingeniería de xAI. ¡Vaya tela!

Google Gemini 2.5: Una inmersión en la IA que quiere pensar (mucho) más grande

Los "system prompts": ¿el talón de Aquiles de la IA?

Este caso plantea la cuestión de los "system prompts". ¿Qué son? Imagínalos como las instrucciones iniciales, una especie de "constitución" dada a una IA para guiar su comportamiento y respuestas. Si alguien modifica estas instrucciones básicas, la IA puede empezar a decir cualquier cosa. Aparentemente, eso fue lo que le pasó a Grok, que también comenzó a hablar de "genocidio blanco" —una teoría conspirativa promovida por el propio Elon Musk— incluso cuando se le hacían preguntas sin relación alguna. Un usuario en X (antes Twitter) incluso bromeó diciendo que alguien había reprogramado a Grok con "letras de Slipknot como visión del mundo sobre la autoridad". Qué ambiente.

Ante estos fallos, xAI prometió publicar sus "system prompts" en GitHub (una plataforma de código abierto) e implementar "verificaciones y medidas adicionales".

IA saudí: cuando un humano sueña con desafiar a Google y China gracias al petrodólar

Un "bug" que deja perplejos

Pero la explicación del simple "bug" o de la "modificación no autorizada" no convence a todos. Otro usuario en X expresó su escepticismo. Según él, modificar "system prompts" implica procesos y aprobaciones complejas. Sería "literalmente imposible que un actor malintencionado aislado hiciera este cambio". Dos opciones para este lector: "o bien un equipo en xAI modificó intencionalmente este system prompt de manera específicamente dañina, O xAI no tiene ninguna seguridad implementada". Una paradoja que cuestiona la solidez y supervisión de estas herramientas cada vez más presentes en nuestras vidas.

El caso Grok pone de manifiesto la fragilidad de estas inteligencias artificiales ante temas sensibles. Si un "simple" error de programación o una acción maliciosa puede descarrilarlas así, la cuestión de la confianza y el control se vuelve crucial. xAI se comprometió a reforzar sus salvaguardias. Esperemos que sea suficiente para evitar que la IA se convierta en una máquina de propagar falsedades históricas.

Jerome

Experto en desarrollo web, SEO e inteligencia artificial, mi experiencia práctica en la creación de sistemas automatizados se remonta a 2009. Hoy en día, además de redactar artículos para descifrar la actualidad y los desafíos de la IA, diseño soluciones a medida e intervengo como consultor y formador para una IA ética, eficiente y responsable.